Das Problem mit manuellen Deployments

Wer kennt es nicht: Ein kritischer Fix muss in Production, aber niemand traut sich so richtig. Die Tests wurden “lokal ausgeführt”, die Integration “sollte funktionieren”. Das Ergebnis ist oft vorhersehbar.

Pipeline-Dauer

Statt 45 Min manuell

Tests automatisiert

Unit, Integration, E2E

Success Rate

Mit Quality Gates

Rollback-Zeit

Bei Problemen

Nach Jahren in verschiedenen Teams habe ich gelernt: Der Unterschied zwischen chaotischen und stabilen Deployments liegt in gut durchdachten Quality Gates. Nicht in perfekten Prozessen oder teuren Tools, sondern in pragmatischen Checkpoints, die Fehler früh abfangen.

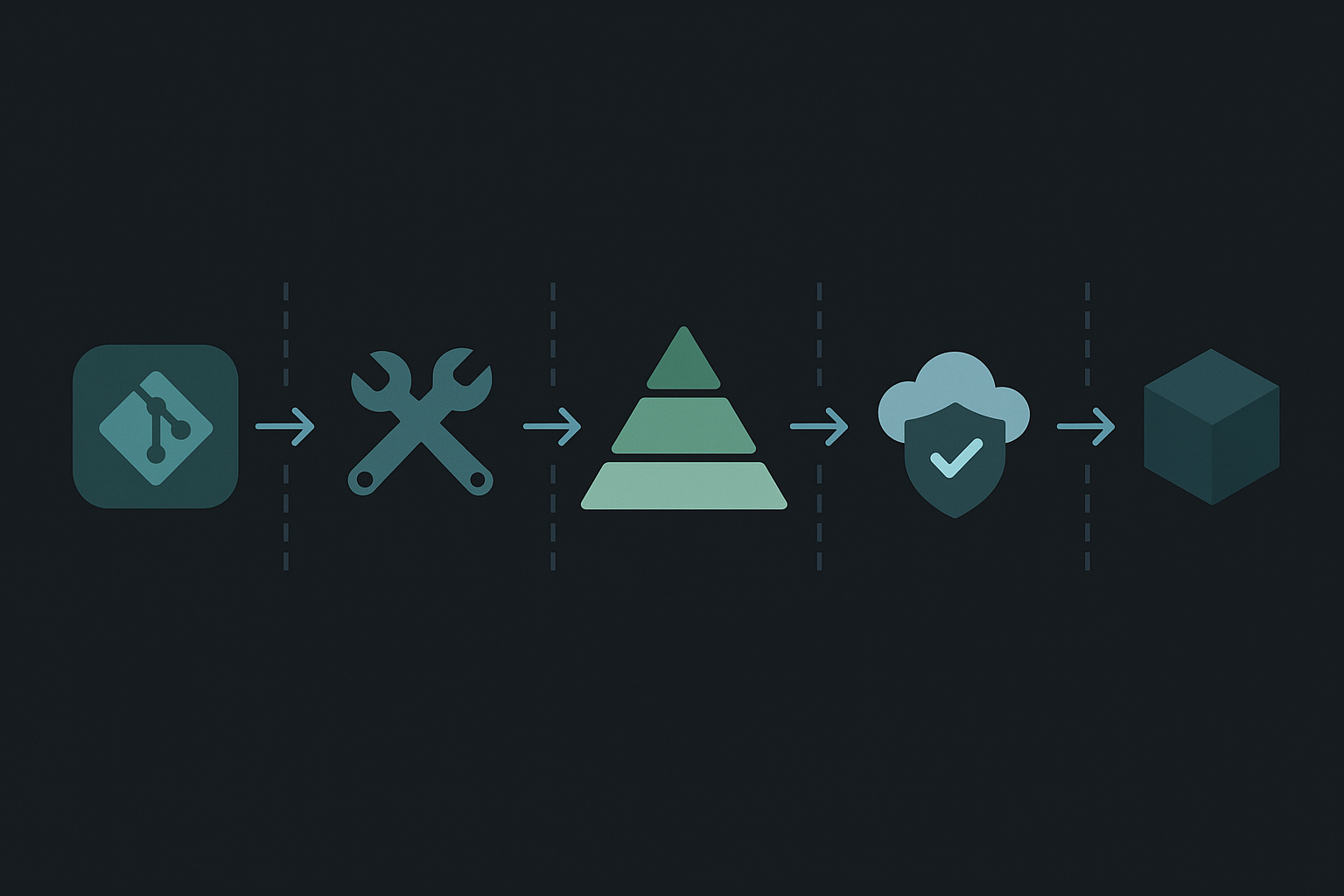

Interaktive Pipeline-Visualisierung

Bevor wir in die Details gehen, hier eine interaktive Visualisierung einer modernen CI/CD-Pipeline. Sie zeigt alle wichtigen Stages von Commit bis Production:

💡 Tipp: Die Visualisierung zeigt den Datenfluss durch die Pipeline. Jede Stage fungiert als Quality Gate mit spezifischen Checks.

Die Testpyramide als Grundlage

Die Testpyramide ist ein simples Konzept, das oft missverstanden wird. Es geht nicht darum, möglichst viele Tests zu haben, sondern die richtigen Tests zur richtigen Zeit. In der obigen Visualisierung sehen Sie, wie die verschiedenen Test-Typen in die Pipeline integriert sind.

/\

/E2E\ <- Wenige, langsame Tests (10%)

/------\

/Integr. \ <- Moderate Anzahl (20%)

/----------\

/ Unit Tests \ <- Viele, schnelle Tests (70%)

/______________\Unit Tests (Die Basis)

Unit Tests sind der Workhorse jeder Pipeline. Sie laufen in Millisekunden und prüfen isolierte Funktionen. Ein Beispiel aus einem aktuellen Projekt: Wir hatten 3000+ Unit Tests, die in unter 30 Sekunden durchliefen. Das ermöglichte schnelles Feedback bei jedem Commit.

Der Trick dabei: Unit Tests müssen wirklich isoliert sein. Keine Datenbankzugriffe, keine API-Calls, keine Dateisystem-Operationen. Alles wird gemockt. Das macht sie schnell und zuverlässig.

Integration Tests (Die Mitte)

Integration Tests prüfen, ob Komponenten zusammenarbeiten. Typisches Beispiel: Ein API-Endpoint, der Daten aus der Datenbank holt. Hier nutzen wir TestContainers für eine echte Postgres-Instanz, die für jeden Testlauf frisch gestartet wird.

Diese Tests dauern länger (bei uns etwa 2-3 Minuten für 200 Tests), finden aber Probleme, die Unit Tests nicht sehen können: SQL-Syntax-Fehler, falsche Joins, Transaktionsprobleme.

E2E Tests (Die Spitze)

End-to-End Tests simulieren echte User-Interaktionen. Wir nutzen Playwright für kritische User Journeys: Login, Checkout, Hauptfeatures. Mehr als 20-30 E2E Tests sind meist Overkill - sie sind langsam, flaky und teuer in der Wartung.

Ein Learning aus der Praxis: E2E Tests nur für business-kritische Pfade. Alles andere testet man besser auf niedrigeren Ebenen.

Vorher vs. Nachher: Der Unterschied ist dramatisch

Deployment-Prozess im Vergleich

❌ Ohne CI/CD Pipeline

Total: 45-60 Minuten

🔄 Manuelle Schritte fehleranfällig

⚠️ Keine automatischen Rollbacks

⏰ Zeitintensiv und repetitiv

✅ Mit CI/CD Pipeline

Total: 12 Minuten

✨ Vollautomatisch und reproduzierbar

🎯 95% Success Rate

⚡ 4x schneller als manuell

Quality Gates in der Pipeline

Quality Gates sind automatische Checkpoints, die entscheiden, ob Code weitergehen darf. In der Visualisierung oben sind sie als Verbindungen zwischen den Stages dargestellt - jede mit spezifischen Bedingungen. Hier unsere wichtigsten Gates:

Gate 1: Build & Compile

Klingt trivial, ist aber wichtig. Der Code muss kompilieren, Dependencies müssen auflösbar sein, Linting-Regeln erfüllt. Dauert bei uns unter 2 Minuten. Schlägt dieses Gate fehl, geht nichts weiter.

Gate 2: Unit Tests & Coverage

Alle Unit Tests müssen grün sein. Code Coverage sollte nicht unter einen definierten Wert fallen (bei uns 80%). Wichtig: Coverage ist kein Selbstzweck. 80% sinnvolle Tests sind besser als 100% mit sinnlosen Assertions.

Gate 3: Security Scanning

Automatische Checks auf bekannte Vulnerabilities in Dependencies. Wir nutzen Trivy, das in unter einer Minute durchläuft. Critical Issues blockieren sofort, High Issues erzeugen Warnings.

Ein praktischer Tipp: Nicht jede “High” Vulnerability ist wirklich kritisch für eure Anwendung. Kontext matters. Aber ignoriert sie nicht einfach - dokumentiert, warum ihr sie akzeptiert.

Gate 4: Integration Tests

Hier wird’s interessant. Integration Tests in der CI sind eine Herausforderung. Unsere Lösung: Eine dedizierte Test-Datenbank, die nach jedem Run zurückgesetzt wird. TestContainers für externe Services. Das Gate blockiert bei fehlgeschlagenen Tests oder wenn die Performance drastisch abfällt.

Gate 5: Deployment in Staging

Nach allen Tests deployen wir automatisch in eine Staging-Umgebung. Smoke Tests prüfen, ob die Anwendung überhaupt startet und basic Health-Checks durchlaufen. Erst wenn das funktioniert, ist der Code bereit für Production.

Multi-Service Deployments

In einer Microservice-Architektur wird’s komplexer. Services haben Dependencies, müssen in der richtigen Reihenfolge deployed werden.

Service-Dependency Management in der Praxis

Unser Ansatz: Service-Independence durch API-Versioning. Jeder Service muss mit der vorherigen Version der anderen Services funktionieren.

Beispiel: User-Service Update

Deployment-Strategien im Detail

🔵 Blue-Green

Zwei identische Umgebungen

🐤 Canary Release

Schrittweises Rollout

🚩 Feature Flags

Deploy ≠ Release

Feature Flags in Action:

if (featureFlags.isEnabled('new-checkout')) {

return renderNewCheckout();

}

return renderLegacyCheckout();Mein persönlicher Favorit: Code ist deployed aber deaktiviert. Aktivierung ohne neues Deployment.

Wenn’s schiefgeht: Rollback-Strategien

Trotz aller Gates gehen Dinge schief. Wichtig ist, wie schnell man reagieren kann.

Automatische Rollbacks triggern bei uns bei: Error-Rate über 5%, Response-Time über 2 Sekunden (p95), Memory/CPU über 90%. Das System switched automatisch zur letzten stabilen Version.

Manuelle Rollbacks sind manchmal nötig bei Business-Logic-Fehlern, die technisch korrekt sind. Beispiel: Ein Rabatt-Code, der 90% statt 9% Rabatt gibt. Technisch läuft alles, Business ist not amused.

Learnings aus der Praxis

Nach mehreren Jahren mit CI/CD-Pipelines in verschiedenen Teams:

Fangt klein an. Nicht gleich die perfekte Pipeline bauen wollen. Erst Build automatisieren, dann Tests, dann Deployment. Step by step.

Tests müssen schnell sein. Wenn die Pipeline 30 Minuten läuft, nutzt sie keiner. Optimiert für Geschwindigkeit. Parallelisiert wo möglich.

Flaky Tests sind Gift. Ein Test, der random fehlschlägt, zerstört das Vertrauen in die Pipeline. Entweder fixen oder löschen.

Monitoring ist wichtiger als Tests. Ihr könnt nicht alles testen. Aber ihr könnt alles monitoren. Gute Observability findet Probleme, die Tests nie gefunden hätten.

Menschen sind wichtiger als Prozesse. Die beste Pipeline nützt nichts, wenn das Team sie nicht versteht oder umgeht. Holt alle ins Boot, erklärt das Warum, nicht nur das Was.

Tools sind zweitrangig

Jenkins, GitLab CI, GitHub Actions - am Ende ist es egal. Wichtiger sind die Prinzipien: Automatisierung, schnelles Feedback, sichere Rollbacks.

Wir nutzen GitHub Actions, weil es gut in unseren Stack passt. Vorher war’s Jenkins, davor TeamCity. Die Migration war jeweils in einer Woche erledigt, weil die Konzepte gleich blieben.

Der wichtigste Tipp

Wenn ihr nur eine Sache aus diesem Artikel mitnehmt: Automatisiert eure Deployments. Nicht perfekt, nicht vollständig, aber automatisiert. Manuelle Deployments sind der größte Risikofaktor in der Software-Entwicklung.

Jeder manuelle Schritt ist eine Fehlerquelle. Jede Checkliste wird irgendwann ignoriert. Automation vergisst nicht, macht keine Tippfehler, deployed nicht aus Versehen auf dem falschen Server.

Fazit

CI/CD mit Quality Gates ist kein Hexenwerk. Es ist die konsequente Anwendung simpler Prinzipien: Teste früh, teste oft, automatisiere alles, sei bereit für Rollbacks.

Die Testpyramide gibt die Struktur vor, Quality Gates setzen sie durch. Das Ergebnis: Schnellere, sicherere Deployments mit weniger Stress für alle Beteiligten.

Start where you are, use what you have, do what you can. Der beste Zeitpunkt für CI/CD war gestern, der zweitbeste ist heute.