Was ist LM Studio?

LM Studio ist eine Desktop-Anwendung für Windows, macOS und Linux, mit der sich Open-Source Language Models lokal ausführen lassen. Die Software bietet eine grafische Oberfläche für Modelle, die sonst nur über die Kommandozeile nutzbar wären.

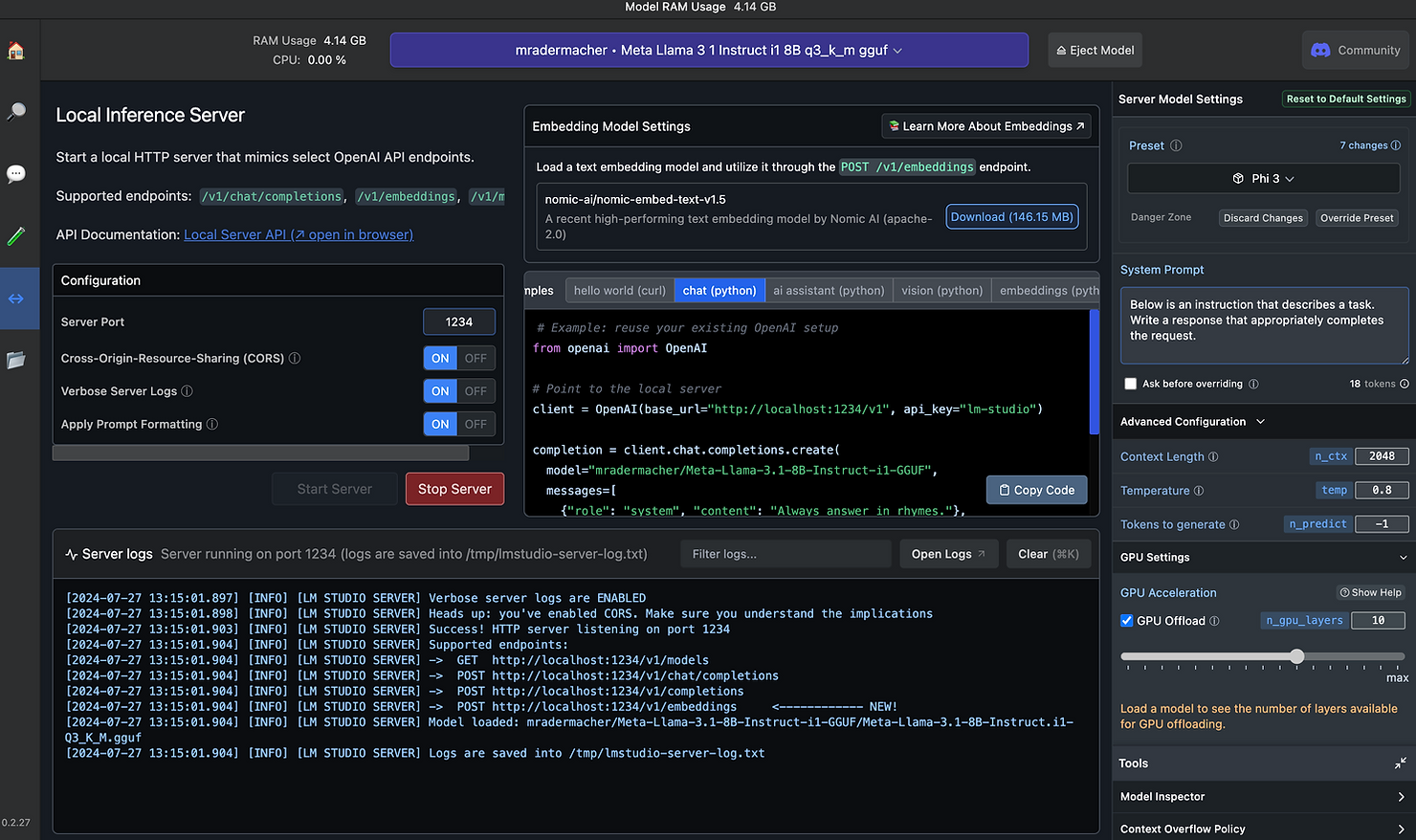

Das Programm lädt Modelle direkt von Hugging Face herunter und bietet sowohl ein Chat-Interface als auch eine OpenAI-kompatible API. Letzteres bedeutet: Bestehende Anwendungen, die mit ChatGPT arbeiten, lassen sich oft durch einfaches Ändern der API-URL auf lokale Modelle umstellen.

Installation und erste Schritte

Die Installation ist unkompliziert: Software von lmstudio.ai herunterladen und installieren. Nach dem Start präsentiert LM Studio eine Übersicht verfügbarer Modelle.

Für den Einstieg eignen sich kleinere Modelle wie Phi-3 oder Llama-3.1-8B. Diese benötigen zwischen 4 und 8 GB Speicherplatz und laufen auch auf durchschnittlicher Hardware flüssig. Größere Modelle wie Mixtral bieten bessere Ergebnisse, brauchen aber entsprechend mehr Ressourcen.

Praktische Anwendungsfälle

Dokumentenanalyse ohne Datenschutzrisiko

Vertrauliche Dokumente, Verträge oder interne Berichte können analysiert werden, ohne dass Daten das Unternehmensnetzwerk verlassen. Das ist besonders für Branchen mit strengen Compliance-Anforderungen relevant.

Code-Entwicklung

Modelle wie CodeLlama unterstützen bei der Programmierung. Der eigene Code bleibt dabei lokal - keine Sorge um Intellectual Property oder versehentlich geleakte Geschäftsgeheimnisse.

Offline-Verfügbarkeit

Nach dem Download funktionieren die Modelle komplett ohne Internet. Das ist praktisch für Arbeiten in abgeschotteten Umgebungen oder unterwegs.

Kostenaspekt

Statt monatlicher API-Gebühren fallen nur einmalige Hardware-Kosten an. Bei intensiver Nutzung kann sich das schnell rechnen.

Warum lokale KI?

Der Hauptvorteil liegt in der Datenkontrolle. Keine Nutzerdaten werden an externe Server übertragen, was DSGVO-Compliance vereinfacht und Datenlecks verhindert.

Zudem gibt es keine Rate-Limits oder Ausfallzeiten durch überlastete Server. Die Performance hängt nur von der eigenen Hardware ab.

Ein weiterer Punkt: Modellauswahl. Während Cloud-Dienste meist nur ihre eigenen Modelle anbieten, stehen bei LM Studio hunderte verschiedene Open-Source-Modelle zur Verfügung. Man kann verschiedene Modelle für unterschiedliche Aufgaben nutzen oder spezialisierte Varianten einsetzen.

Systemanforderungen

Minimum:

- 8 GB RAM (für kleine Modelle)

- 10 GB freier Speicherplatz

- Windows 10, macOS 12 oder Ubuntu 20.04

Empfohlen:

- 16-32 GB RAM

- Dedizierte Grafikkarte (NVIDIA mit CUDA oder Apple Silicon)

- 50+ GB Speicher für mehrere Modelle

Die GPU-Beschleunigung macht einen deutlichen Unterschied - Antworten kommen etwa 5-10x schneller als bei reiner CPU-Nutzung.

Grenzen und Überlegungen

Lokale Modelle erreichen (noch) nicht die Qualität von GPT-4 oder Claude. Für viele Anwendungsfälle reichen sie aber völlig aus. Die Modellgröße ist durch den verfügbaren Arbeitsspeicher begrenzt - die besten Open-Source-Modelle mit 70B+ Parametern brauchen High-End-Hardware.

Updates und neue Modelle muss man selbst verwalten. Dafür hat man volle Kontrolle über Versionen und kann bei Bedarf auf ältere Modelle zurückwechseln.

Fazit

LM Studio macht KI-Technologie zugänglich, ohne Kompromisse beim Datenschutz einzugehen. Für Unternehmen mit sensiblen Daten oder Entwickler, die unabhängig arbeiten wollen, ist es eine praktische Alternative zu Cloud-Diensten.

Die Software entwickelt sich stetig weiter und die verfügbaren Open-Source-Modelle werden immer besser. Wer Wert auf Datenkontrolle legt oder einfach experimentieren möchte, sollte LM Studio ausprobieren.