Was passiert, wenn du einen Newsletter nicht nur mit KI schreibst, sondern auch mit KI prüfen lässt? Nicht mit einem Agenten – mit vier. Parallel. Das Elegante daran: Jeder hat eine andere Perspektive.

Das Ergebnis ist bks-news: Ein wöchentlicher AI-Newsletter, der durch einen 6-Phasen-Workflow läuft, bevor er veröffentlicht wird.

Die 4-Augen-Regel (aber mit KI)

Ein Agent sieht Fakten. Ein anderer sieht Bias. Ein dritter sieht Struktur. Ein vierter sieht Risiken. Zusammen sehen sie mehr als du allein.

Das ist meine Faustregel für KI-generierte Inhalte: Vier spezialisierte Perspektiven schlagen einen Generalisten.

Das Problem mit AI-generierten Inhalten

AI kann schreiben. Schnell. Viel. Aber:

Halluzinationen

Fakten erfunden, Zahlen falsch, Zitate verzerrt

Einseitigkeit

Hype-Narrative, fehlende Kritik, keine Gegenperspektiven

Urheberrecht

Copy-Paste von Texten, externe Bilder = Abmahnrisiko

Die Lösung? Checks and Balances – aber automatisiert.

Die Architektur: 4 Agenten, 4 Perspektiven

🔄 Multi-Agent-Validierung

🔍 Fact-Check Agent

Verifiziert alle Fakten gegen Originalquellen:

- • Alle Zahlen und Prozente

- • Alle Zitate (Wortlaut + Zuordnung)

- • Alle Daten und Release-Dates

- • Superlative (“erster”, “größter”)

WebFetch → Original-Artikel → Vergleich

😈 Devil’s Advocate Agent

Hinterfragt jede Story kritisch:

- • Einseitige Narrative entdecken

- • Fehlende Perspektiven aufzeigen

- • Hype vs. Substanz unterscheiden

- • Gegenargumente recherchieren

WebSearch → Kritische Quellen → Balance

✏️ Quality Editor Agent

Prüft Struktur und Vollständigkeit:

- • Alle 10 Sektionen vorhanden?

- • Links funktionieren?

- • Ton konsistent?

- • Frontmatter vollständig?

Struktur-Check → Style-Guide → Fixes

⚖️ Legal Compliance Agent

BLOCKER – Prüft Urheberrecht:

- • Keine externen Bilder (§2 UrhG)

- • Keine 1:1 Textübernahme

- • Zitate korrekt attributiert (§51 UrhG)

- • Alle Quellen verifiziert

Verstöße = Veröffentlichung blockiert

Alle 4 Agenten laufen parallel in einem einzigen API-Call. Das macht den Unterschied: ~3 Minuten statt ~12 Minuten sequentiell.

Der 6-Phasen-Workflow

📡 Quellensammlung (5 min)

RSS-Feeds von TechCrunch, Ars Technica, The Verge + WebSearch für Breaking News. Ergebnis: 15-20 potenzielle Stories.

WebFetch(rss-feeds) + WebSearch(“AI news this week”)

🎯 Story-Selektion (10 min)

User wählt 5-7 Stories. Für jede: Deep Dive per WebFetch. Extraktion von Kernaussagen, Zitaten, Zahlen.

🚦 Gate: User bestätigt Auswahl

📝 Draft-Generierung (5 min)

10-Sektionen-Struktur: TL;DR, Story der Woche, Top-Stories, Quick Hits, Tool/Fail/Zahl der Woche, Leseliste, Ausblick.

🚦 Gate: User reviewt Draft

🤖 Multi-Agent-Validierung (3 min)

4 spezialisierte Agenten prüfen parallel. Legal Compliance ist Blocker – Verstöße verhindern Veröffentlichung.

Task(fact-check) || Task(devil) || Task(quality) || Task(legal)

✅ Finalisierung (2 min)

Korrekturen einarbeiten, finaler Review, Commit ins Repository. GitHub Actions deployen automatisch.

git commit → GitHub Actions → GitHub Pages

🌍 EN-Übersetzung (5 min)

Optionale englische Version. Kulturelle Anpassungen, gleiches Format. Separates Content-Directory für i18n.

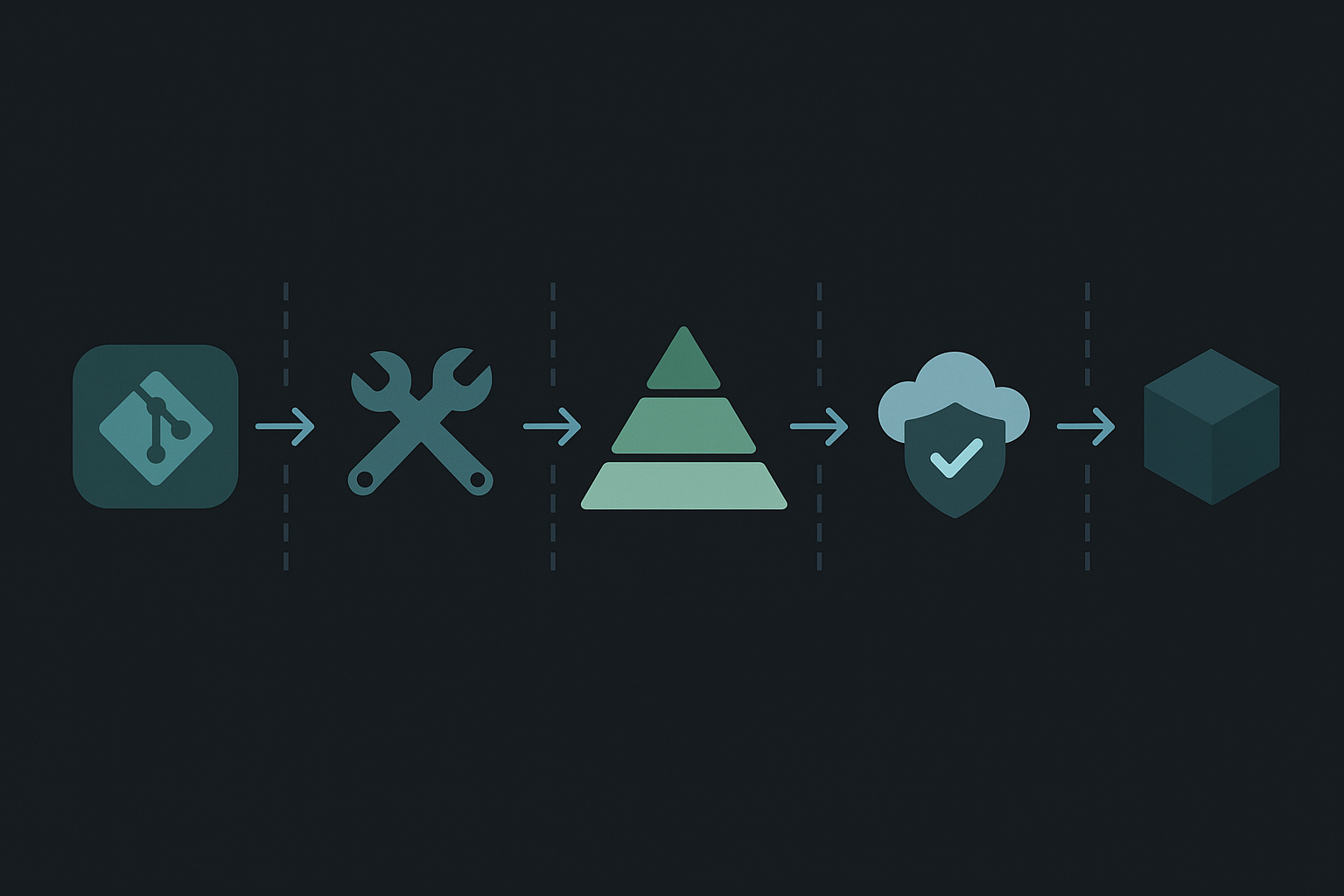

Der Tech-Stack

| Komponente | Technologie | Warum |

|---|---|---|

| Static Site | Astro 5 | Content Collections, Zero JS by default |

| Content | Markdown + Zod | Type-safe Frontmatter, Git-versioniert |

| Generation | Claude Code + Skills | 6-Phasen-Workflow als Skill definiert |

| Validierung | 4 parallele Subagenten | Spezialisierte Perspektiven |

| Scheduling | launchd + Claude Scheduler | Montag 8:00 automatisch |

| Hosting | GitHub Pages | Kostenlos, CI/CD integriert |

Die Content-Pipeline

Warum diese Architektur?

“Warum nicht einfach GPT/Claude direkt nutzen?”

Ein einzelner Agent hat Blind Spots. Der Fact-Checker prüft Zahlen, aber nicht Balance. Der Devil’s Advocate hinterfragt alles, prüft aber keine Urheberrechte. Spezialisierung + Parallelisierung = bessere Ergebnisse.

“Warum User-Gates statt Full-Auto?”

Human-in-the-Loop für kritische Entscheidungen: Welche Stories sind relevant? Welche Korrekturen sind nötig? Full-Auto für repetitive Tasks, Human für Judgment Calls.

“Warum Static Site statt CMS?”

Git = Single Source of Truth. Jeder Newsletter ist ein Commit. Rollback jederzeit möglich. Kein Server = keine Angriffsfläche. GitHub Actions = kostenlose CI/CD.

Das Ergebnis

bks-news in Zahlen

Was ich dabei gelernt habe

Der wichtigste Punkt: Mehr Agenten ≠ besser. Vier ist der Sweet Spot – genug Perspektiven, wenig Overhead. Mit zwei Agenten hast du zu wenig Abdeckung, mit sechs wird’s unübersichtlich.

Was noch nicht perfekt läuft:

- Der Devil’s Advocate ist manchmal zu kritisch – da muss ich die Prompts noch nachschärfen

- Manche Stories brauchen mehr manuelle Recherche als andere

- Die EN-Übersetzung könnte kulturell besser angepasst sein (amerikanische Beispiele statt deutsche)

Stand heute funktioniert das System – aber ich iteriere weiter. Das ist der Kern von agentic coding: Bauen, testen, verbessern.

Selbst ausprobieren?

bks-news ist live und wird wöchentlich aktualisiert. Der Generator-Skill ist Teil meines Claude Code Setups.